L’intelligenza artificiale salverà la qualità dei contenuti?

Un’analisi realistica tra fact-checking, veridicità e trasparenza

Viviamo in un’epoca dominata dai contenuti digitali. Ogni giorno vengono pubblicati milioni di post, articoli, video, podcast, commenti e approfondimenti, generati da persone, aziende e – sempre più spesso – da intelligenze artificiali. In questo oceano di informazioni, la vera sfida non è più solo creare contenuti, ma garantirne la qualità, l’accuratezza e la veridicità.

Nel mezzo di questo cambiamento epocale, ci chiediamo: l’intelligenza artificiale può diventare uno strumento efficace per migliorare la qualità dei contenuti online? Può contribuire al fact-checking, alla lotta contro la disinformazione e alla trasparenza delle fonti?

In questo articolo analizziamo in modo realistico e critico il potenziale dell’IA in questo campo, distinguendo promesse concrete da hype, con uno sguardo al presente e uno al futuro.

🧠 Il contesto attuale: contenuti ovunque, verità in crisi

La facilità con cui oggi si possono produrre contenuti ha un rovescio della medaglia: la quantità ha superato la qualità. Ecco alcune tendenze ormai sotto gli occhi di tutti:

I social network premiano la viralità, non l’accuratezza.

Il clickbait è ancora una strategia dominante.

La disinformazione – anche involontaria – si diffonde a velocità virale.

Le redazioni sono sotto organico e spesso non hanno tempo per il fact-checking.

Nel frattempo, i modelli di intelligenza artificiale come ChatGPT, Gemini o Claude stanno rivoluzionando il modo in cui scriviamo e consumiamo contenuti. Ma possono anche contribuire a verificarli?

🤖 IA e contenuti: da generazione a verifica

L’IA è già molto avanzata nella generazione di contenuti: articoli, email, descrizioni prodotto, persino video deepfake. Ma il prossimo grande passo sarà l’integrazione dell’IA nel controllo della qualità e della veridicità dei contenuti stessi.

Vediamo in che modo.

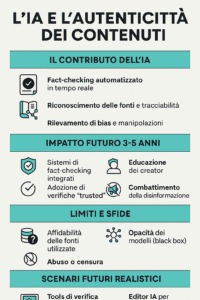

✅ 1. Fact-checking automatizzato e assistito

Uno dei campi più promettenti è il fact-checking in tempo reale. Grazie ai LLM (Large Language Models) e all’accesso a database aggiornati (Wikipedia, database scientifici, archivi di notizie), l’IA è in grado di:

confrontare un’affermazione con decine di fonti in pochi secondi;

segnalare incongruenze o dati potenzialmente falsi;

suggerire fonti più autorevoli o aggiornate.

Esempi concreti già esistono: strumenti come ClaimReview, Full Fact, o il fact-checking automatico di Google usano modelli IA per suggerire se un’affermazione è vera, falsa o imprecisa. In futuro questi strumenti saranno integrati nei CMS (Content Management System) come WordPress, Substack o Ghost, aiutando i creator a verificare i dati mentre scrivono.

📚 2. Tracciabilità delle fonti e origine dei contenuti

Un altro uso chiave dell’IA sarà quello di tracciare le fonti di un contenuto:

identificare la fonte primaria di una notizia, anche se riformulata o decontestualizzata;

segnalare se un’informazione proviene da un sito dubbio o una fonte anonima;

distinguere tra contenuti originali e rimaneggiamenti sospetti (es. copy-paste da social, manipolazioni ideologiche).

Strumenti IA di “source tracing” aiuteranno a contestualizzare meglio le informazioni, valorizzando le fonti affidabili.

🛡️ 3. Rilevamento di bias e manipolazioni

L’IA può essere addestrata per riconoscere linguaggi distorsivi, espressioni ideologiche estreme, bias cognitivi, omissioni e generalizzazioni pericolose. Ad esempio:

titoli costruiti per evocare paura o indignazione;

narrazioni unilaterali su temi politici, scientifici o sociali;

pattern linguistici associati a propaganda o manipolazione.

Già oggi ci sono strumenti come HateSonar, Perspective API (di Google) e GPT-f (OpenAI) che identificano linguaggi tossici, polarizzanti o imprecisi.

📈 Evoluzione nei prossimi 3-5 anni

Siamo solo all’inizio. Ecco come potremmo vedere evolvere l’IA nei prossimi anni nel campo della qualità dei contenuti.

| Area | Evoluzione attesa |

|---|---|

| Verifica dei fatti | IA integrata in piattaforme editoriali, CMS e social per controllo automatico o assistito |

| Etichettatura contenuti | Badge “Verified by AI” o “Fact-checked” visibili nei risultati di ricerca o nei feed social |

| Educazione dei creator | Plugin e assistenti IA che aiutano gli autori a migliorare accuratezza, chiarezza e struttura |

| Contenuti istituzionali | Media, PA, ONG useranno IA per garantire trasparenza e affidabilità |

| Prevenzione disinformazione | IA che segnala in automatico contenuti manipolati o fuorvianti in tempo reale |

⚠️ I limiti dell’intelligenza artificiale nel fact-checking

Non tutto è rose e fiori. L’uso dell’IA nel controllo della verità presenta diversi limiti e rischi.

1. Fonti inaffidabili o incomplete

Se i modelli sono addestrati su dataset che contengono errori, fake news o bias, l’IA può amplificare la disinformazione invece di contrastarla. È il classico problema del “garbage in, garbage out”.

2. Mancanza di trasparenza (black box)

Gli LLM sono spesso opachi: non sempre spiegano perché una determinata affermazione è considerata vera o falsa. Questo è un problema soprattutto in ambiti delicati (medicina, diritto, geopolitica).

3. Dipendenza tecnologica

Affidarsi totalmente all’IA potrebbe portare i creatori di contenuti a disabituarsi al pensiero critico. Il rischio è delegare troppo.

4. Censura algoritmica

Il potere di segnalare o rimuovere contenuti ritenuti “falsi” potrebbe essere abusato da governi autoritari o da aziende con conflitti di interesse. Serve etica, trasparenza e supervisione umana.

🔮 Scenari futuri: tra ottimismo e realismo

🌟 Scenario ottimistico (2027+)

Ogni contenuto digitale ha un badge che ne certifica origine, verificabilità, livello di accuratezza.

Le piattaforme social bloccano in tempo reale contenuti palesemente falsi, grazie a IA distribuite e aggiornate costantemente.

Gli utenti possono visualizzare perché un contenuto è stato considerato fuorviante o errato.

I giornalisti usano IA come copiloti nella ricerca delle fonti, nell’analisi di documenti, nella sintesi delle fonti multiple.

🧩 Scenario realistico (2025–2026)

Gli strumenti di IA vengono adottati da testate giornalistiche, istituzioni e grandi piattaforme per assistere nella verifica, ma non per decidere da soli.

I creator più attenti alla qualità usano strumenti IA come editor semantici intelligenti.

L’uso dell’IA per verificare contenuti diventa uno standard professionale nel content marketing, SEO e comunicazione aziendale.

👥 Il ruolo insostituibile dell’umano

L’IA può fare moltissimo, ma non può sostituire il pensiero critico umano. Ecco perché il futuro migliore è quello in cui IA e persone lavorano insieme.

L’IA velocizza la raccolta e l’analisi dei dati, ma l’essere umano decide cosa è rilevante.

L’IA segnala potenziali errori, ma l’essere umano li contesta, li corregge, li contestualizza.

L’IA può aiutare a distinguere il vero dal falso, ma l’essere umano deve decidere cosa è giusto raccontare, e come.

📌 Conclusione

L’intelligenza artificiale sta cambiando radicalmente il modo in cui creiamo, leggiamo e giudichiamo i contenuti. Nei prossimi anni, diventerà uno strumento fondamentale per chi vuole:

produrre contenuti verificabili e affidabili;

aumentare la credibilità di brand e professionisti;

combattere attivamente la disinformazione online.

Tuttavia, l’IA non è infallibile, e il rischio di abusi o automatismi ciechi è reale. La chiave sarà un’integrazione etica e responsabile tra tecnologia e pensiero umano.

Chi saprà padroneggiare questi strumenti, senza delegare tutto alla macchina, sarà protagonista della nuova era dell’informazione.